Sitemap และ Robots.txt: คู่มือที่ Google อ่านก่อนใคร

ในกระบวนการทำ SEO มีหลายองค์ประกอบที่ต้องให้ความสำคัญ แต่มีสองไฟล์ที่หลายเว็บไซต์มองข้าม ทั้งที่เป็นเหมือน "คู่มือแนะนำ" ให้ Google รู้ว่าควรทำความรู้จักกับเว็บไซต์ของเรายังไง นั่นคือ Sitemap XML และ robots.txt

สองไฟล์นี้มีบทบาทสำคัญในการควบคุมการเก็บข้อมูล (Crawling) และจัดอันดับ (Indexing) บน Google Search อย่างชัดเจน โดยเฉพาะกับเว็บไซต์ที่มีเนื้อหาจำนวนมากหรือมีการอัปเดตบ่อย

Sitemap XML คืออะไร?

Sitemap คือไฟล์ที่บอก Google ว่าบนเว็บไซต์ของเรามีหน้าอะไรบ้าง และหน้าไหนสำคัญที่สุด ซึ่งช่วยให้ Google Bot เข้าไปเก็บข้อมูลได้รวดเร็วและมีประสิทธิภาพ

ประโยชน์ของ Sitemap:

-

แจ้งหน้าใหม่ที่ยังไม่มี Backlink ให้ Google รู้

-

เร่งการ Index เนื้อหาหลังจากอัปเดต

-

ระบุความถี่ในการอัปเดตแต่ละหน้า (Change Frequency)

-

กำหนดความสำคัญของแต่ละหน้า (Priority)

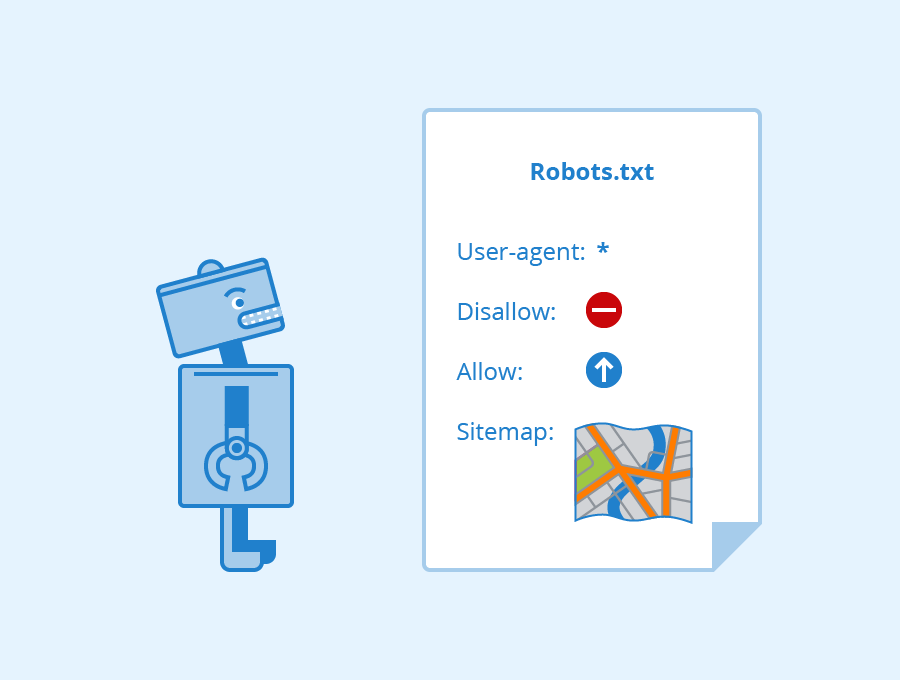

robots.txt คืออะไร?

robots.txt คือไฟล์ที่ควบคุมว่า Google (หรือ Bot อื่น ๆ) จะ เข้าไปเก็บข้อมูลหน้าใดได้ และห้ามหน้าใด

ตัวอย่างคำสั่งใน robots.txt:

-

Disallow: /admin/ – บอกว่าไม่ให้บอทเข้าหน้านี้

-

Allow: /content/ – ให้เข้าถึงเฉพาะไดเรกทอรีนี้

-

Sitemap: https://www.domain.com/sitemap.xml – บอกตำแหน่งของ Sitemap

หากเขียนผิด หรือปิดการเข้าถึงหน้าโดยไม่ได้ตั้งใจ อาจทำให้หน้าเว็บสำคัญหลุดจากการจัดอันดับได้ทันที

แนวทางที่แนะนำ

-

สร้าง Sitemap XML แบบ Dynamic ที่อัปเดตอัตโนมัติเมื่อมีการเพิ่ม/ลบหน้า

-

เชื่อมโยง Sitemap ใน robots.txt เพื่อให้ Google พบได้ง่าย

-

ส่ง Sitemap ผ่าน Google Search Console

-

หมั่นตรวจสอบ robots.txt ว่าไม่มีคำสั่งที่ไปปิดกั้นหน้าที่สำคัญโดยไม่ได้ตั้งใจ

กรณีศึกษา: Srichand

Srichand แบรนด์เครื่องสำอางชื่อดัง มีเว็บไซต์ E-Commerce ที่มีการเพิ่มสินค้าบ่อยครั้งและจัดโปรโมชั่นใหม่แทบทุกสัปดาห์ ทีมของ Senna Labs เข้าไปช่วยปรับโครงสร้างเว็บไซต์ด้าน SEO และพบว่าเว็บไซต์ยังไม่มีระบบ Sitemap อัตโนมัติ

การปรับปรุงที่ดำเนินการ

-

สร้าง Sitemap XML ที่เชื่อมตรงกับฐานข้อมูลสินค้า ให้ทุกการอัปเดตถูก Sync โดยอัตโนมัติ

-

เพิ่มบรรทัด Sitemap: ใน robots.txt

-

ส่ง Sitemap ใหม่เข้าสู่ Google Search Console พร้อมการวัดผลในช่วง 2 เดือนหลังอัปเดต

ผลลัพธ์ที่ได้

-

Google index หน้าใหม่เร็วขึ้น 3 เท่า จากเดิมที่ต้องรอหลายวัน เหลือเพียงไม่กี่ชั่วโมง

-

สินค้าใหม่เริ่มแสดงใน Google Search ภายใน 1 วันหลังโพสต์

-

ลดการสูญเสียโอกาสทางการตลาดในช่วงเปิดตัวผลิตภัณฑ์ใหม่

สรุป

การมี Sitemap และ robots.txt ที่ถูกต้องและอัปเดตตลอดเวลา คือพื้นฐานที่เว็บไซต์ทุกประเภทควรมี ไม่ว่าจะเป็นเว็บข่าว เว็บขายของ หรือเว็บแนะนำบริการ เพราะสิ่งเหล่านี้ช่วยให้ Search Engine เข้าใจโครงสร้างเว็บไซต์ และเก็บข้อมูลได้ครบถ้วนและเร็วขึ้น

หากเว็บไซต์ของคุณยังไม่มีระบบ Sitemap อัตโนมัติ หรือไม่แน่ใจว่า robots.txt เขียนถูกหรือไม่ ทีมของ Senna Labs พร้อมช่วยวิเคราะห์และวางโครงสร้าง SEO ด้านเทคนิคให้ถูกต้องและมีประสิทธิภาพ

Subscribe to follow product news, latest in technology, solutions, and updates

บทความอื่นๆ

Let’s build digital products that are simply awesome !

We will get back to you within 24 hours!ติดต่อเรา Please tell us your ideas.

Please tell us your ideas.